Il nuovo supercomputer di Leonardo e i passi avanti del quantum computer nel mondo

Nel 1994, Peter Shor, un matematico che lavorava presso i laboratori Bell nel New Jersey, dimostrò che un computer quantistico avrebbe avuto le capacità intrinseche di risolvere alcuni problemi in maniera esponenzialmente più veloce di una qualsiasi altra macchina per così dire classica. La domanda fu subito: sarebbe stato possibile costruirne uno con queste caratteristiche? Gli scettici sostenevano che gli stati quantistici erano troppo delicati: l’ambiente in cui operavano avrebbe inevitabilmente confuso le informazioni nel computer quantistico, rendendolo in sintesi non quantistico.

Un anno dopo, Shor comprese invece come i classici schemi di correzione degli errori avrebbero misurato i singoli bit per verificare la presenza di errori. Tale approccio non avrebbe funzionato per i bit quantistici, o “qubit”, poiché qualsiasi misurazione effettuata in questo caso avrebbe distrutto lo stato quantistico, e quindi il calcolo nel suo insieme. Shor trovò il modo per rilevare se si era verificato un errore senza misurare lo stato del qubit stesso. Il codice di Shor segnò l’inizio nel campo della correzione degli errori quantistici e l’esplosione di questo particolare settore contraddistinto, fra le altre cose, dal fiorire della tecnologia applicata ai supercomputer.

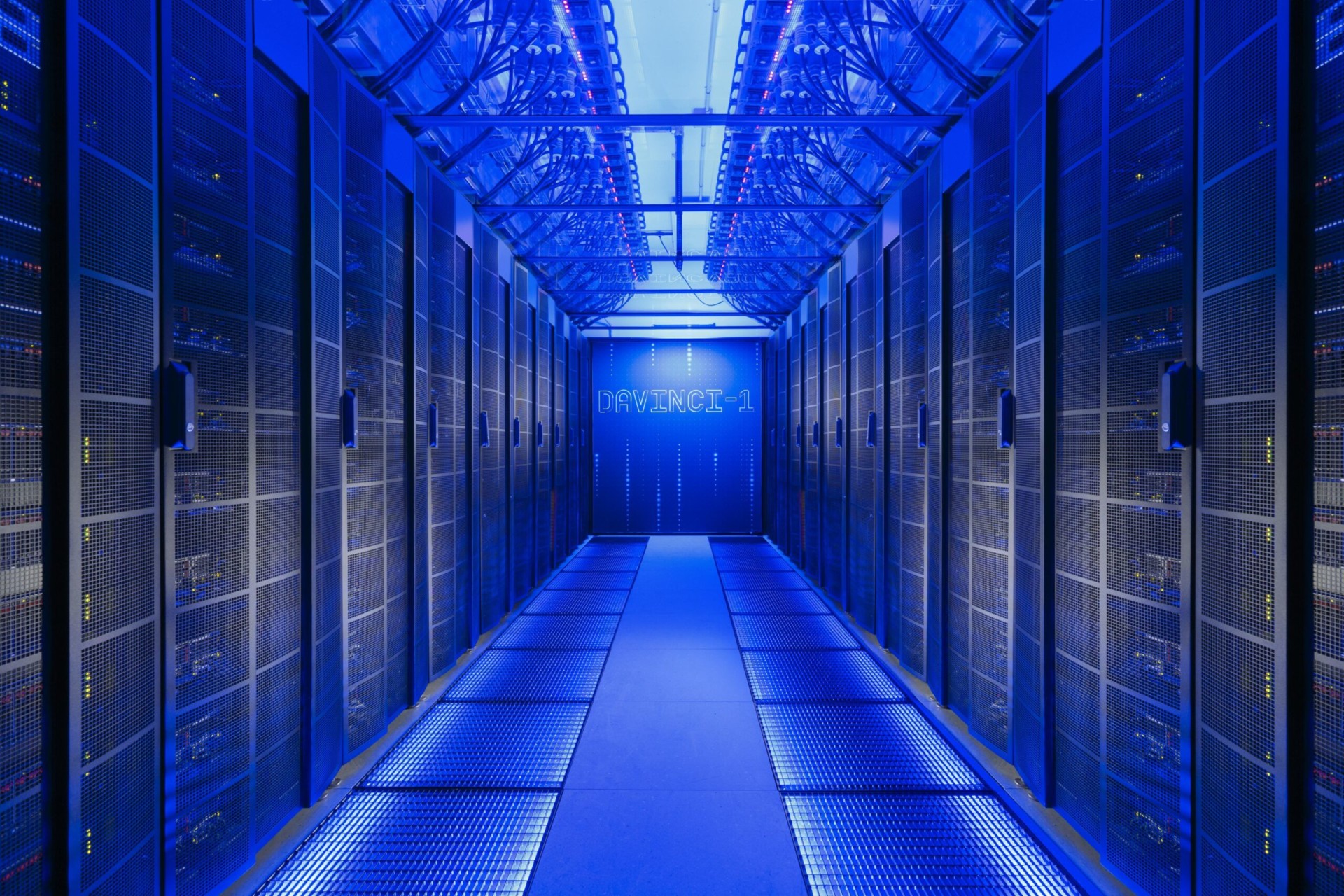

È notizia di qualche giorno fa della nascita del nuovo supercomputer della società Leonardo chiamato Davinci-1, installato nel super laboratorio della società che si trova a Torre Fiumara a Genova e simbolo di innovazione e sviluppo dell’Italia in Italia.

Più di 5 milioni di miliardi di operazioni in virgola mobile al secondo, pari a 10.000 personal computer di ultima generazione. 200 server installati a Torre Fiumara. 20 milioni di gigabyte di memoria. 1000 Gbyte al secondo di velocità complessiva di lettura e scrittura, sufficiente a leggere e scrivere 20 DVD al secondo.

Un’accelerazione potentissima di Leonardo sulle tecnologie disruptive che rappresentano il presente e il futuro dell’innovazione: Artificial Intelligence e Autonomous Intelligent System, Big Data Analytics, High Performance Computing, Electrification of Aeronautical Platforms, Materials and Structures e Quantum Technologies.

Il supercomputer rappresenta un gioiello nel panorama italiano, un acceleratore di conoscenza capace di potenziare il processo di digitalizzazione industriale con ricadute dirette per lo sviluppo competitivo dell’intero Paese.

Ogni volta che una nuova tecnologia si impone sulla precedente cambia la nostra percezione rispetto a ciò che esisteva prima. Continuiamo a rincorrere miliardi di giga esasperati da una progressiva rincorsa all’inseguimento della più recente novità. La nostra percezione del tempo cambia col mutare delle nostre abitudini. Concetti quali pausa, attesa o pazienza sembrano appartenere ad un’epoca che non esiste più. Chi ricorda d’altra parte le sospirate connessioni con i primi modem a 54k? Ciò che una volta era accettabile, oggi non lo è più. La nostra ansia da prestazione nasce da questa bramosia di onniscienza che ci spinge a voler sapere e a poter accedere a tutto senza mai attendere. Se qualcosa si sa subito, allora lo si sa veramente; viceversa, una qualsiasi forma di riflessione e di risposta tardiva (ma tardiva rispetto a cosa?) appare come sintomo di debolezza. Tutto nel nostro mondo ormai spinge per far sembrare lento ciò che era sinonimo di velocità fino a poco tempo fa.

L’Italia, sebbene ben posizionata nel mondo, galleggia intorno alla sesta posizione nella classifica delle macchine più performanti stilata dal sito specializzato top500.org. Con 1,5 miliardi di gigaflops invece (un miliardo e mezzo di miliardi di operazioni con virgola mobile al secondo) gli Stati Uniti sono l’economia con la maggiore potenza di calcolo installata. La Cina segue con 1,1 miliardi di gigaflops mentre si trova in Giappone il supercomputer più veloce al mondo.

Il suo nome è Fugaku, è installato a Kobe presso il Riken Center for Computational Science ed ha una velocità di calcolo inimmaginabile che gli permette di offrire una mostruosa potenza espressa in 415,5 quadrilioni di calcoli al secondo (petaflop). Per dare un’idea concreta della velocità di esecuzione di questa macchina l’Università dell’Indiana ha calcolato che per stare al passo di un supercomputer a un solo petaflop si dovrebbe eseguire un calcolo ogni secondo per 31.688.765 anni. Moltiplicando questo valore per i 415,5 petaflop di Fugaku dovresti eseguire un calcolo ogni secondo per circa 13,2 miliardi di anni.

Supercomputer, dati, intelligenza artificiale, cyber sicurezza, sono solo alcuni degli asset strategici alla base dell’attuale rivoluzione industriale digitale. I dati, in particolare, rappresenteranno sempre di più la vera moneta di scambio del futuro.

L’enorme computer Fugaku non sarà pienamente operativo fino al prossimo anno, ma la sua formidabile potenza di elaborazione è già all’opera nella lotta al Coronavirus e per la ricerca COVID-19 in diagnostica, terapia e simulazioni che prevedano modelli di analisi per la diffusione del virus.

L’auspicio è che l’Uomo sappia maneggiare le informazioni che produce e che si scambia in questo ecosistema globale. Sono gli uomini, infatti, ad immaginare, costruire e lavorare con le macchine. I valori etici dovranno sopravvivere all’evoluzione e guidare le scelte di coloro che governeranno le nostre identità digitali. Con una visione ottimistica per la scienza, fiducia nel futuro e buona pace per i NO-Cloud.